Electrical energy storage at utility scale remains both the Holy Grail for electric industry redesign and one of the most vexing energy technology challenges. Storage applications may include:

•Peak shaving (load leveling) systems to help commercial and industrial users manage electricity costs under variable utility tariffs and to help utilities manage generating assets to minimize waste.

•Renewable integration systems to help power producers, utilities, and end-users cope with the inherent variability of wind and solar power, transforming it into firm, dispatchable power, and to better match peak wind and solar output with peak demand.

•Power quality systems to protect commercial and industrial users from interruptions that cost an estimated $75 billion to $200 billion per year in lost time, lost commerce, and damage to equipment.

•Transmission and distribution support systems to help utilities reduce grid congestion, defer upgrades, and minimize waste.

Because utilities still depend on spinning reserve and other supply-side strategies to ensure reliability -- and even conduct long-term planning based on the assumption that energy storage will not be viable in the foreseeable future -- adding energy storage into the system will significantly disrupt the current energy ecosystem. Implementing an advanced smart grid will help utilities to develop a vision based on the potential of affordable energy storage, where they will move from R&D to active trials of various technologies in different parts of their service territory.

The use of energy storage does not need to cause any loss of comfort or convenience, but rather to accept some minor sharing of the resource in a collective strategy to pull in a new resource that has never existed before. An advanced smart grid will enable solutions that leverage distributed energy resources, tapping into some that haven’t yet been conceived. Integration with other assets, including distributed generation, demand response, electric vehicles (EVs), virtual power plants (VPPs), micro-grids, and utility-side smart grid technologies will be vital to maximizing the value of each individual new resource, but also of the collective advanced smart grid. With a network and smart grid optimization engine, all these distributed elements can be optimized and their potential realized.

Challenges in creating a utility energy storage program from a strategic perspective will include not only energy storage integration, but also designing the system and prioritizing energy storage locations. Energy storage is likely to be located where there is congestion on the grid.

The role of energy storage in a disaster recovery situation will need to be considered. Energy storage will be valuable in restoration of electricity service after a massive outage. Prioritizing distributed generation and energy storage for disaster shelters will buy utilities time, since there will be a minimal amount of power assured in those spots in the case of a prolonged outage. Co-location of distributed generation (DG) and energy storage (ES) with disaster shelters supports utility goals in a disaster recovery plan.

VPPs describe a demand-side alternative to accommodate growth in peak demand to the traditional supply-side alternative of adding a natural gas power plant, commonly referred to as a peaking unit or a peaker.

At the micro level, VPPs require technology to be refined at the scale of a single distribution feeder or neighborhood.

At the macro level, integrating a VPP system to the grid will require the ability to manage new levels of complexity in remote sensing, control, and dispatch. Integration of the complex VPP systems will require the utility control center to be able to “see” the status and availability of such distributed capacity. The complexity of system dispatch with these types of resources will require automated decision-making to signal a direct load curtailment condition to DR resources to make optimal use of these new resources and integrate into the larger system portfolio.

New control software now available in the market is designed to enable utilities to manage the numerous and complex dispatch requirements of such distributed energy resources as VPPs. Intelligent edge devices such as smart meters, smart routers, and smart inverters are now capable of communicating their operational status, calculating the ramifications of their actions on their surrounding environment, and making decisions to change their state in real time so that the network becomes self-healing and self-adapting. Autonomous, edge-based decision-making maintains safe energy flows, minimizes service disruptions, and, perhaps most importantly, helps to avoid catastrophic damage. Such a distributed network of smart devices connected to VPPs will provide them the intelligence they need to create new demand action capabilities that integrate new edge-based resources seamlessly with the advanced smart grid.

VPPs and micro-grids represent an emerging resource and application of creative bundling of multiple technologies. New concepts and thinking about how a grid works will be needed for these approaches to take hold.

For instance, while initial adopters of these solutions may have off-grid operations in mind (which we call Step 1 or “disconnect”), the actual realization of these concepts will be difficult. Step 2 could be called “independent operation,” and it will borrow from our knowledge of how we operate the grid today. Step 3 is likely to concern resource islanding, with a focus on “reconnection for reliability.” Step 4, which we could call “replacement,” will finally be realized as NFTE is implemented as policy.

As VPPs and micro-grids mature, they will become the LANs and WANs in the Smart Grid 3.0 world, connected by an energy internet and offering new levels of independence and interdependence that we have barely contemplated today.

• Where the early grid developers embraced access to cheap, plentiful fossil fuels like coal, petroleum, and natural gas, building ever larger, more efficient coal-fired power plants, today we’re challenged to avoid the carbon that results from burning fossil fuels.

• Where grid resources on the supply side expanded to meet a growing population and increasing use of electricity, today we’re challenged to involve consumers to avoid peak load by making better use of existing and new types of distributed energy resources.

• Where production and distribution of electricity were central to planning and building the grid, today we also focus on our built infrastructure to use energy more efficiently and to better understand energy consumption behavior patterns.

• Using cost plus ratemaking to establish revenue targets for regulated utilities, the keystone of the twentieth-century “regulatory compact” that allowed monopoly franchises is giving way today to considerations of ecosystem impacts, decoupling, and more frequent true-ups to meet the needs of society and a variety of stakeholders in a more dynamic environment.

• When information used to be scarce and expensive, utilities devised ingenious, artful methods to plan and operate the complex grid, but in today’s environment of abundant, low-cost information, we are challenged to add sensors to gather ever more data, and then use data analytics to plan, operate, and manage complexity.

• Late in the twentieth century, retail competition showed faltering progress and potential, and while markets still have a prominent role to play, in the twenty-first century communities out on the edge will leverage social networking, smart mobile devices, and other lessons learned from the internet to identify and deliver greater value.

• Finally, where automated meter reading (AMR) evolved into advanced metering infrastructure (AMI) and led the charge to deliver a smart grid, in the twenty-first century we will need a more expansive definition of smart grid, based on a new smart grid architecture to incorporate edge power by design, which we call the advanced smart grid.

Source : GreenTechMedia

Excerpt from The Advanced Smart Grid: Edge Power Driving Sustainability by Andres Carvallo and John Cooper.

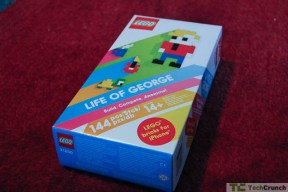

Lego (or LEGO if you’re adamant about trademarks) has just dipped another toe into electronic gaming with their clever “Life Of George” iOS title. The game uses 144 pieces and a piece of cardboard covered in a dotted pattern. The game is simple: George shows you a picture from his travels and asks you to recreate it using Legos. You have to dig around in your box of pieces to recreate the image and then take a picture of it on the Playmat. Using a brick recognition system from Eye-Cue, the game awards you points for speed and accuracy.

Lego (or LEGO if you’re adamant about trademarks) has just dipped another toe into electronic gaming with their clever “Life Of George” iOS title. The game uses 144 pieces and a piece of cardboard covered in a dotted pattern. The game is simple: George shows you a picture from his travels and asks you to recreate it using Legos. You have to dig around in your box of pieces to recreate the image and then take a picture of it on the Playmat. Using a brick recognition system from Eye-Cue, the game awards you points for speed and accuracy.

NRG Energy and the University of Delaware (UD) have teamed up in a venture called eV2g to commercialize technology that lets electric-vehicle (EV) owners sell back energy stored in their car batteries to help stabilize the electricity grid.

NRG Energy and the University of Delaware (UD) have teamed up in a venture called eV2g to commercialize technology that lets electric-vehicle (EV) owners sell back energy stored in their car batteries to help stabilize the electricity grid.

Ford propose à ses clients de suggérer des améliorations à apporter à leur véhicule, tant du point de vue de l'équipement que des logiciels. Les projets réalisables peuvent ensuite être mis au point et distribués.

Ford propose à ses clients de suggérer des améliorations à apporter à leur véhicule, tant du point de vue de l'équipement que des logiciels. Les projets réalisables peuvent ensuite être mis au point et distribués.

Reality Touch permet de représenter un élément de mobilier dans un univers réel sur une tablette. Il suffit de poser une feuille à l'endroit de la pièce où l'on souhaite voir s'afficher l'objet.

Reality Touch permet de représenter un élément de mobilier dans un univers réel sur une tablette. Il suffit de poser une feuille à l'endroit de la pièce où l'on souhaite voir s'afficher l'objet.