Notre objectif est de mettre en partage sur nos trois spécialisations (stratégies et management de l'innovation business tous secteurs, stratégies de croissance ENERGIE et CLEANTECH, stratégies de croissance DIGITAL), les analyses d'Innhotep, celles de nos invités et des articles tiers issus de notre veille. Accélérateur d' "innovations business", Innhotep intervient comme conseil auprès de grands groupes et accompagne le développement de start-up high-tech.

- Innovations business (327)

- Innovations énergétiques (764)

- Innovations numériques (1334)

lundi 31 mai 2010

Une leçon d'éco-entrepreneuriat à Berkeley : Cleantech To Market (C2M)

La formule est pourtant simple "Etudiants+Scientifiques+Professionnels = Innovation", mais le résultat est spectaculaire. Pour sa première édition, le programme issu d'un partenariat unique entre l'université de Berkeley et les scientifiques affiliés à cette institution (dont le fameux Lawrence Berkeley National Laboratory, pour ne citer que lui), a encore démontré la prééminence des américains, et même pourrait-on dire des californiens, en matière d'innovation technologique. Ambitionnant de favoriser le développement de technologies vertes, pour la plupart encore en gestation dans les laboratoires, et la formation de leaders éco-reponsables, C2M [1] réalise le pari de faire interagir le monde étudiant (tous les éléments de la promotion sont issus des différentes Graduate School de Berkeley afin de favoriser la multiplicité des points de vue), et de la recherche.

Chaque groupe, réunissant 4 étudiants et une équipe de chercheurs sur un projet d'innovation dans les énergies renouvelables, est encadré par une cohorte de professionnels de très haut niveau issus du monde de l'entrepreneuriat, de l'investissement, de la finance, parachevant ainsi l'excellence de la formation. La dizaine de projets qui a été présentée touche des domaines aussi variés que le stockage de l'énergie, des capteurs intelligents ou bien encore du solaire. Nous avons fait le choix, certes partial, de ne discuter ici que les deux projets "solaires" qui nous ont semblé extrêmement prometteurs.

Du solaire modulaire pour les pays en voie de développement

Partant du constat qu'il n'existe pas à l'heure actuelle de technologie solaire adaptée à une utilisation dans les régions les plus pauvres de la planète, pourtant généralement très généreusement dotées en ensoleillement, Cyrus Wadia [2], désormais conseiller du Président Obama pour la question solaire, a développé un nouveau type de cellules photo-voltaïques pour pallier ce manque. L'innovation technique se base sur la technologie couche-mince, dont les avantages principaux résident dans sa grande flexibilité d'utilisation et la faible quantité de matériau nécessaire à la production, en dépassant une de ses principales limitations à savoir l'utilisation de matériaux rares dont l'approvisionnement pourrait poser problème. Le composé retenu est donc le Cu2S qui présente, en plus d'être extrêmement abondant, l'avantage de n'être pas toxique (contrairement au cadmium utilisé habituellement) et d'être très bon marché. La deuxième innovation, elle commerciale, se situe au niveau du marché visé : l'éclairage des régions rurales d'Inde. Chaque indien pourrait ainsi disposer de son propre panneau sur mesure et qu'il pourrait utiliser selon son besoin, ponctuellement. L'efficacité visée de ces panneaux d'ici 2014 est de 6% et serait amplement suffisante pour le marché.

Better Silicon, de l'amélioration de l'efficacité des cellules cristallines

Ce projet a lui été beaucoup plus discret sur le principe scientifique qui le sous-tend car une création de structure est très sérieusement envisagée par la suite, à la seule condition de réunir les 2 millions de dollars nécessaires à la fabrication des prototypes... Better Silicon s'inscrit dans la filière solaire cristalline ; une des faiblesses principales de cette technologie est le coût de production des modules proportionnel à la quantité de silicium nécessaire (rappelons brièvement la récente crise du silicium quand le prix du kilogramme était de $500, il est maintenant redescendu à un tarif plus raisonnable de $60...). La technologie permettrait une réduction des coûts de production des cellules en divisant pas 10 la quantité de silicium nécessaire usuellement à la fabrication de ces cellules, ce pour une efficacité identique. Pour une même quantité de silicium, l'efficacité de la cellule pourrait, selon les prévisions être augmentée de 25% au moins. La distribution de licences à des fabricants de panneaux permettrait théoriquement à l'horizon 2016 (la société deviendrait profitable en 2014) de dégager un revenu net de 3 millions de dollars avec des perspectives de croissance très alléchantes.

Ce programme prouve encore l'incroyable dynamisme de la Californie, capable d'offrir des moyens et des infrastructures à la hauteur de ses ambitions en matière de développement durable et de compétitivité. Un exemple pour le reste du monde...

ORIGINE : BE Etats-Unis numéro 207 (14/05/2010) - Ambassade de France aux Etats-Unis / ADIT - http://www.bulletins-electroniques.com/actualites/63341.htm

La puissance de calcul à la rescousse du changement climatique

Alors que le prix des matières premieres (pétrole, gaz, or, riz) ne cesse d'augmenter, celui de la puissance de calcul continue de diminuer.

En effet un corollaire intéressant de la loi de Moore, du nom d'un des fondateurs d'Intel qui avait prédit que la puissance de calcul allait doubler tous les ans, est que l'énergie utilisée pour faire un calcul donné se retrouve divisée par 2 toutes les 1,5 années. Ces résultats étaient récemment présentés lors d'une conférence à Berkeley par Jonathan Koomey, expert en efficacité énergétique et chercheur à Stanford et au Lawrence Berkeley National Lab [1].

Ce constat était au centre de bon nombre des présentations qui ont eu lieula semaine dernière à l'occasion de la Conférence Green:Net 2010 à San Francisco, qui se focalisait sur la convergence des technologies de l'information (IT) et des technologies propres (cleantech) [2].

Idealab, la labo à idées vertes

Pour Bill Gross, entrepreneur chevronné et directeur de l'incubateur d'idées Idealab [3] dont est notamment issu le géant du solaire thermique E-Solar, le calcul est simple: la puissance de calcul coute de moins en moins cher, et la consommation énergétique diminuant de manière impressionnante, c'est une commodité dont il faut user et abuser pour s'attaquer aux autres problèmes qui affectent notre environnement et sont cause de réchauffement climatique.

Une illustration flagrante de ce principe se retrouve dans le portfolio des entreprises issues d'Idealab:

E-Solar, développeur de ferme solaire-thermique

Les fermes sont composées d'un champ de petits panneaux réflecteurs plats qui renvoient la lumière du soleil vers une tour et permettent de générer de la vapeur pour activer une turbine et générer de l'électricité. La force d'E-Solar est d'utiliser des petits panneaux plats dont le montage peut se faire en usine et l'installation est relativement simple, permettant de minimiser les couts de main d'oeuvre. La taille des panneaux étant relativement petite, des panneaux plats peuvent suffire et cela permet de limiter les couts de fabrication.Enfin quatre tours encerclent le champ des panneaux et utilisent des algorithmes de traitement d'image pour reconnaitre l'ensemble des panneaux et ainsi les orienter de manière optimale. Ces algorithmes peuvent travailler de manière rapide et efficace sur l'ensemble des panneaux et ainsi maximiser l'énergie générée. Donc tout est finalement question d'optimisation, que ce soit au niveau du design, du procédé d'installation, et du pilotage de la ferme.

Infinia, le moteur Stirling optimal obtenu par algorithmes génétiques

Le moteur Stirling [4] est un moteur à énergie externe, par comparaison aux moteurs à combustion interne. C'est une machine thermique qui transforme l'énergie transférée entre deux sources externes (une chaude et une froide) en énergie mécanique (génératrice d'électricité) par l'intermédiaire d'un fluide confiné à l'intérieur du moteur, soumis à un cycle thermodynamique fermé. Aucune combustion n'a lieu à l'intérieur du moteur et le chauffage se fait à l'extérieur grâce notamment à l'énergie solaire.

Le premier projet de Bill Gross, alors étudiant, fut de vendre des plans d'un moteur Stirling par correspondance lors des pénuries de 1973. Cela lui permit alors de financer une partie de ses études. Aujourd'hui sa société Inifinia a développé un moteur Stirling de rendement optimal, gràce à l'utilisation d'algorithmes génétiques. Plutôt que de construire de multiples modèles et de les tester, l'équipe d'Infinia a simulé une grande population de modèles et leur rendement. Elle a par la suite sélectionné les deux meilleurs modèles et les a combinés, et a répété le processus sur un grand nombre de générations, arrivant au final à un modèle avec un rendement optimal augmenté de 40%. Selon Bill Gross, la puissance de calcul nécessaire pour y arriver n'était pas disponible il y a 5 ans. Cela présage de nombreuses utilisations de ce procédé.

Aptera Motors, la voiture dont le Cx est inférieur à celui d'un cycliste du tour de France

C'est aussi la puissance de calcul qui est au centre du projet d'Aptera Motors, fabricant de voitures électriques. Le modèle d'Aptera consomme actuellement 5 fois moins d'essence que la plus performante des Prius de la dernière génération. Ce résultat est le fruit d'un long travail d'optimisation et d'étude de l'écoulement d'air autour de la carrosserie, grâce encore un fois à la modélisation. Cette dernière permet notamment d'évaluer les conséquences de chaque choix technique: insérer les roues à l'intérieur de la carrosserie, ajouter un aileron, etc... Elle permet aussi de gagner du temps, de l'argent, et de limiter l'impact sur l'environnement. Pour Bill Gross, c'est l'utilisation de cette puissance de calcul toujours plus grande et toujours moins couteuse qui nous permettra de nous attaquer à tous nos problèmes sur l'environnement, et à les surmonter.

Google ne produit pas assez de gaz à effet de serre ?

Google était aussi très présent à cette conférence: Bill Weihl, le Monsieur Energie de Google, présentait les résultats d'une étude sur la consommation énergétique des Data Centers qui se trouvent au coeur de l'activité de Google. Selon lui les technologies de l'information sont responsables de 2% des émissions de gaz à effet de serre. Un résultat de son étude qui parait contradictoire est qu'il faudrait que ce pourcentage augmente, devenant une part plus importante d'un montant total en diminution. Cela devrait passer aussi par la mise en place de mesures d'efficacité énergétique au niveau de l'équipement de ces Data Centers.

Une autre personnalité de Google, Edward Lu, était là pour débattre avec Microsoft sur les différences conceptuelles entre les produits concurrents qu'ils développent sur ce marché, à savoir Google Power Meter [5] et Microsoft Hohm [6], et qui doivent tirer leur potentiel de la mise en place du réseau intelligent. Le positionnement est toujours différent: Google est actuellement dans une stratégie de création des partenariats avec les distributeurs d'électricité et de facilitation d'accès aux données, qui prendront leur sens une fois agrégées, sans pour autant chercher à créer un flot de revenu associé, alors que Microsoft se focalise sur le service associé à ces informations au niveau du consommateur et à générer un revenu basé sur une économie d'énergie du consommateur.

Les acteurs des technologies de l'information sont tous en train de se positionner sur le domaine de l'énergie, que ce soient les opérateurs ou les géants de l'internet. Ils observent la mise en place du réseau intelligent et cherchent à trouver leur marché et leurs débouchés: en tant que logiciel de support au niveau de la distribution, sur le marché de la sécurité des informations qui vont circuler dessus, sur celui des logiciels d'exploitation de ces informations pour les entreprises et les particuliers. Ce qui est certain c'est qu'avec l'arrivée du réseau intelligent, des sources d'énergie renouvelables, et des véhicules électriques, il y aura des besoins immenses en développement d'outils de supports pour contrôler la consommation.

Origine : BE Etats-Unis numéro 206 (7/05/2010) - Ambassade de France aux Etats-Unis / ADIT - http://www.bulletins-electroniques.com/actualites/63272.htmv

Coût et méconnaissance pourraient freiner l'essor du smart grid

Si les infrastructures de distributions énergétiques dites intelligentes se déploient aux Etats-Unis, les fournisseurs peinent à capter l'attention des consommateurs alors que la nécessité des investissements s'accentue.

Une trentaine d'Etats expérimentent actuellement la mise en place de réseaux dits intelligents aux Etats-Unis, note PriceWaterhouse Cooper dans une étude*. Autant d'initiatives qui mettent à jour un certain nombre de défis à dépasser pour un déploiement efficace : problèmes liés au budget, nécessité d'assurer la concrétisation de partenariats avec d'autres industries et d'engager le consommateur. Le cabinet souligne ainsi que près des deux tiers des entreprises impliquées devraient augmenter leurs projets prévisionnels en 2011. Une hausse causée principalement par les systèmes de communication à mettre en place, les installations des compteurs électriques et leurs maintenances. Des factures qui s'empilent et qui devraient atteindre prés de 75 milliards de dollars en 2010, soit plus du double qu'en 2008. Pour autant et malgré ces multiples investissements, l'étude précise qu'il est difficile de prévoir si les bénéfices seront à la hauteur des coûts investis.

Un travail de sensibilisation de la clientèle

Et ce, principalement à cause du manque de visibilité à long terme sur le comportement des consommateurs, face à cette technologie innovante. Car au cœur de ce projet, la principale nécessité est d'inviter les clients à l'adopter. Mais PWC, se basant sur une étude complémentaire, révèle que prés de 70 % des Américains interrogés n'ont jamais entendu parler de ces réseaux de distribution intelligents et écologiques. Et que les deux tiers n'ont même jamais eu connaissance des compteurs électriques intelligents (smart meters). Un travail de sensibilisation de la clientèle et de communication qui s'inscrit dans les challenges à relever par les fournisseurs.

Garantir la régulation du trafic et la sécurité des réseaux

En tant que tel, ils vont devoir apprendre à travailler avec de nouveaux partenaires et réglementer la conduite des vendeurs. L'étude explique aussi que les sociétés devront mettre l'accent sur la gestion de l'offre et de la demande. Au vu des cyber-attaques contre les systèmes de télésurveillances et d'acquisition de données, dont le nombre a doublé depuis 2000, elle préconise de protéger minutieusement les réseaux. Une fois ces défis relevés, les avantages et les économies pour les sociétés et les clients sont considérés comme significatifs par l'étude. Qui souligne que les économies financières et en terme de réduction des émissions de carbone s'annoncent importantes.

* Smart Grid Growing Pains

Source: L'Atelier

mercredi 26 mai 2010

Un modem pour répartir l’énergie entre voisins

Le marché des réseaux intelligents (smart grid) se structure peu à peu, notamment via l’apparition de compteurs intelligents (smart meter). Pour l’instant la grille se résume à un échange entre chaque domicile équipé d’un compteur intelligent et le fournisseurs d’énergie, d’eau ou de gaz. La startup Qurrent propose d’affiner le modèle en ajoutant un échelon intermédiaire grâce à un hub local servant à relier les compteurs intelligents du voisinage. L’objectif est de relier le modem (Qbox) installé chez chaque voisin afin de répartir localement l’énergie renouvelable auto-produite (éolienne, panneaux solaires) pour limiter les pertes en ligne.

Limiter les pertes lors du transport de l’énergie

L’approche de Qurrent a deux avantages. Le premier est de limiter les pertes en ligne en distribuant l’énergie au plus prêt de la source de production. Pour rappel, environ 30% de l’énergie produite est perdue lors de son transport, du fait de l’effet joule notamment. Economiser 30% d’énergie, ce n’est pas rien ! Le second avantage est d’automatiser l’équilibrage entre les sources d’énergie locales et le réseau public pour décharger les serveurs des fournisseurs d’électricité. On peut en effet douter de la pertinence, tant en terme de sécurité que de performances, d’une architecture complètement centralisée comme celle que les fournisseurs d’énergie sont en train de construire. Ajouter le l’intelligence au niveau local apporterait un meilleur niveau de résilience.

Les mesures phares du Grenelle II

Agriculture

- Encadrement de la vente des pesticides et de leur publicité.

- L’AFSSA sera désormais consultée pour le retrait d’un pesticide. Des critères socio-économiques et environnementaux seront également pris en compte.

- Les zones d’habitats naturels seront protégés par la création d’une trame verte et bleue.

- Des objectifs « durables » seront intégrés aux documents d’urbanisme.

- A partir du 1er juillet 2011, la norme RT 2012 imposera une consommation de 50 kWh/m² à tous les bâtiments neufs.

- Les diagnostics de performance énergétique seront systématisés. Ils devront être indiqués dans les annonces immobilières.

- Les bâtiments du secteur tertiaire devront obligatoirement améliorer leur performance énergétique entre 2012 et 2020.

- L’étiquetage vert des produits sera expérimenté pendant un an à partir du 1er juillet 2011. Sa généralisation sera ensuite soumise au Parlement.

- Interdiction des téléphones portables à l’école, de la maternelle au collège.

- Nouvelles mesures d’encadrement de la publicité extérieure et lumineuse. Les maires pourront néanmoins bénéficier de dérogations.

- Les biberons contenant du bisphénol A ne pourront plus être commercialisés en France.

- Installations nucléaires : suppression de l’enquête publique obligatoire pour les demandes d’augmentation des rejets radioactifs et chimiques ainsi que pour celles de prélèvements d’eau.

- Eolien : Objectif national de construction de 500 éoliennes par an ; Minimum de cinq éoliennes par parc ; Classement sous le régime ICPE ; Mise en place de schémas régionaux éoliens ; Garanties financières demandées en prévision du démantèlement du site. (voir l’article du 04.05.10)

- Le bilan carbone devient obligatoire pour les grandes collectivités (plus de 50 000 habitants) et entreprises (plus de 500 salariés)

- Mesure supprimée : seuil de 15 MW imposé à chaque projet éolien.

Transports

- Soutien aux transports collectifs via notamment la réalisation de voies réservées.

- Prix des péages modulé pour les poids lourds selon leur « impact carbone »

- Mesures supprimées : péages urbains pour les villes de plus de 300 000 habitants, modulation « carbone » au péage pour les voitures, dispositif de « taxe poids lourd » (reporté à 2012)

A 100% Renewable Energy Vision for the European Union

Cliquer sur le titre de l'article pour télécharger le document.

mardi 25 mai 2010

Pour comScore, l'efficacité publicitaire dans les jeux vidéo est avérée

Afin de démontrer que les joueurs sont sensibles à la publicité, le cabinet de recherche s'est associé au développeur de jeux Massive, et a mesuré les résultats d'une opération publicitaire pour Bing.com.

Utiliser les jeux vidéo comme un média à part entière pour diffuser de la publicité s'avère tout à fait rentable, proclament conjointement le cabinet de recherche comScore et le créateur de réseaux de jeux vidéo Massive. L'association de ces deux institutions a permis de mettre au point une méthodologie de mesure de l'efficacité publicitaire dans les jeux vidéo - sur console. Les résultats indiquent que la campagne publicitaire menée pour le moteur de recherche Bing de Microsoft, et lancée par Massive, a eu un impact direct sur le comportement des consommateurs. Ceux-ci se rendant sur la plate-forme, et effectuant des recherches, après avoir été confrontés à un message publicitaire dans le jeu. "On est encore en phase d'expérimentation, voire de mise au point de systèmes de mesure des opérations de communication", explique Philippe Torres, directeur des études et du conseil à L'Atelier.

Mesurer précisément l'efficacité publicitaire

"Le fait qu'il y ait une mesure, et qu'elle soit positive est une bonne chose : cela va encourager les annonceurs à prendre conscience que les jeux vidéo numériques sont bien un média à prendre en considération", développe-t-il. L'étude confirme en effet le retour sur investissement que cette option représente. "Nous avons toujours su que les jeux vidéo de Massive représentaient un moyen fort d'engager les marques pour toucher de manière efficace une large audience", affirme JJ Richards, responsable de l'étude. "Désormais, nous pouvons mesurer précisément la réaction des joueurs qui perçoivent ces publicités, de la même façon qu'il est possible de le faire pour d'autres médias", ajoute-t-il. De fait, selon les résultats de l'enquête, le nombre de joueurs ayant effectué une recherche sur le site Bing.com après avoir vu l'une de ces réclames a augmenté de plus de 100% - les deux tiers devenant de nouveaux utilisateurs du moteur de recherche.

L'un des grands médias du futur

60% des joueurs touchés par la publicité ont eu une opinion plus positive de Bing après avoir vu le message publicitaire dans leurs jeux. "La publicité est un bon indicateur : c'est un signal de départ", note Philippe Torres. "Mais la mesure de l'efficacité publicitaire est une chose ; il faut à présent avoir des études sur l'investissement effectif des différents acteurs dans ce média", précise-t-il. Selon lui, le développement de ce canal prendra véritablement son essor lorsque des chiffres seront publiés qui viendront confirmer la tendance. C'est-à-dire lorsque l'on saura précisément quelles sont les dépenses des annonceurs dans ce média. "Une chose est sûre : le jeu numérique sera l'un des grands médias du futur", conclut-il.

Source: L'Atelier

The List Of Startups Launching At TechCrunch Disrupt

conference and we are thrilled to announce the 20 startups that were chosen out of hundreds to present their applications over the next few days. We will also hear pitches from the two StartupAlley companies that receive the most votes over the next two days.

conference and we are thrilled to announce the 20 startups that were chosen out of hundreds to present their applications over the next few days. We will also hear pitches from the two StartupAlley companies that receive the most votes over the next two days. These startups will battle it out over three intense days, with one of these startups eventually taking home $50,000.

Audioo: The Audioo platform allows users to auto-stream, publicly share, and store voicemails from handsets and services including Google Voice.

The Audioo platform allows users to auto-stream, publicly share, and store voicemails from handsets and services including Google Voice.

Appbistro: Appbistro is an application marketplace for Facebook pages.

Appbistro is an application marketplace for Facebook pages.

Art.sy: Art.sy is the destination to discover and share original fine art online.

Art.sy is the destination to discover and share original fine art online.

Betterment: Betterment is intended to be a replacement for your savings account, allowing you to invest in two portfolios.

Betterment is intended to be a replacement for your savings account, allowing you to invest in two portfolios.

ChompOn: ChompOn allows any business to run its own social flash sales.

ChompOn allows any business to run its own social flash sales.

Compass Labs : Compass Labs is a social e-commerce ad network for Twitter.

: Compass Labs is a social e-commerce ad network for Twitter.

Fluidinfo: FluidInfo is a Wikipedia of databases – a shared online always-writable cloud database.

FluidInfo is a Wikipedia of databases – a shared online always-writable cloud database.

Geotoko: Geotoko is a promotional campaign management platform for geo location based services.

Geotoko is a promotional campaign management platform for geo location based services.

Keenkong: Keenkong is a social media monitoring engine that extracts why people are talking, what are they talking about, who they are and then segments messages accordingly.

Keenkong is a social media monitoring engine that extracts why people are talking, what are they talking about, who they are and then segments messages accordingly.

Live Matrix: Live Matrix is a guide to video events and streams taking place on the web.

Live Matrix is a guide to video events and streams taking place on the web.

Movieclips.com : Movieclips.com is an online database of movie clips.

: Movieclips.com is an online database of movie clips.

NoiseToys : NoiseToys is a software company uses games and competition to encourage users to share and discover music.

: NoiseToys is a software company uses games and competition to encourage users to share and discover music.

Off & Away: Off & Away is an online travel site that offers exceptional travel experiences in fun and unique ways.

Off & Away is an online travel site that offers exceptional travel experiences in fun and unique ways.

Publish2: Publish2 allows newspapers to create a comprehensive, customized newswire for print.

Publish2 allows newspapers to create a comprehensive, customized newswire for print.

Soluto: Soluto’s software aims to detect PC users’ frustrations, reveal their cause, learn which actions really eliminate them and improve user experience.

Soluto’s software aims to detect PC users’ frustrations, reveal their cause, learn which actions really eliminate them and improve user experience.

Textingly : Textingly provides a texting address, a web management console and apis for businesses to create immediate, two-way dialog with their customers.

: Textingly provides a texting address, a web management console and apis for businesses to create immediate, two-way dialog with their customers.

Tickreel: Tickreel is a web filter that makes the web less of a black box and significantly improves how users consume the web.

Tickreel is a web filter that makes the web less of a black box and significantly improves how users consume the web.

UJAM : UJAM is a cloud-based platform that allows users to create new music or enhance their existing musical talent and share it with friends.

: UJAM is a cloud-based platform that allows users to create new music or enhance their existing musical talent and share it with friends.

VideoGenie : VideoGenie allows companies to customer-source video testimonials.

: VideoGenie allows companies to customer-source video testimonials.

WeReward: WeReward is a mobile incentive platform that rewards consumers for check-ins or performing tasks.

WeReward is a mobile incentive platform that rewards consumers for check-ins or performing tasks.

vendredi 21 mai 2010

Um, Did Google Just Quietly Launch A Web-Based iTunes Competitor? Yep. Read more: http://techcrunch.com/2010/05/20/um-did-google-just-quietly-launch-

Today at Google I/O, Vic Gundotra introduced Froyo, aka Android 2.2. But he also went a bit beyond Froyo. Coming soon, is a way to download an app through the Android Market over the web — and have it automatically download on your Android devices too. But that’s not all. Gundotra also showed off a new section of the Market — Music. Yes, an iTunes competitor on the web from Google.

Details are sparse at the moment, but here’s how this basically works. You go to the Market on the web, find a song you like, click the download button, and just like with apps, the song starts to download on your Android devices. So it’s iTunes, over the web, with auto-syncing. No word on who the partners are for this, what the prices will be, etc. Undoubtedly, we’ll hear more about that soon.

And that’s not all.

Gundotra also announced that Google recently made an aquisition: Simplify Media. Using this technology, Google will soon offer a desktop app that will give you access to all of your (DRM-free) media on your Android devices remotely.

Search mobile : un marché sur le point d'exploser

|

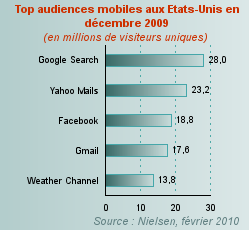

Ainsi, lors d'une présentation qui s'est déroulée en mars 2010, Vic Gundotra, vice-président de Google Engineering, a indiqué que le nombre de recherches sur Google via mobile a déjà quintuplé en l'espace de deux ans à peine, sans donner plus de précisions. En décembre 2009, le moteur de recherche dominait l'audience de l'Internet mobile aux Etats-Unis avec 28 millions de visiteurs uniques, soit 45 % de l'audience selon Nielsen.

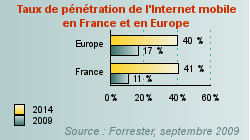

En France, 6,8 millions de Français ont déjà à surfé Internet via mobile, dont presque 3 millions ont utilisé les moteurs de recherche, indique M:metrics dans une étude publiée en mars 2009. Le taux de pénétration de l'Internet mobile atteindrait en effet 11 % en France en 2009 selon Forrester, et potentiellement 41 % en 2014.

|

Difficile pourtant de mesurer la taille du marché du search sur mobile en France, comme à l'étranger d'ailleurs. Les régies ne publient pas leurs chiffres, pas plus que Google. La certitude est que ce marché balbutiant est sur le point d'exploser. Le search sur mobile ne présente pas d'innovation technique particulière et les acteurs sont déjà expérimentés en matière d'optimisation sur l'Internet fixe. Bref, la pratique est mature, seul le support et la consommation d'Internet en phase de mobilité change.

Etudes et professionnels, s'ils ne sont pas forcément d'accord sur les valeurs absolues, s'accordent parfaitement sur le fait que le marché affiche des croissances de deux à trois chiffres, les tendances en France suivant celles des Etats-Unis où les dépenses pèsent déjà des centaines de millions de dollars.

Source: Journal du Net

M-Kesho fait du porte-monnaie mobile un véritable compte bancaire

Le service de m-paiement lancé au Kenya par Safaricom et Equity Bank permet à ses utilisateurs de mettre de l'argent sur un compte rémunéré et d'accéder à des services de micro-crédit et micro-assurance.

Les solutions de m-paiement type, au Kenya, M-Pesa (Safaricom), Zap (Zain) ou YuCash (Yu) permettent de transférer de l'argent de personne à personne, ou de payer son loyer, des factures d'eau et d'électricité sans se déplacer. Autant de services auparavant difficiles d'accès pour des individus non bancarisés, une majorité dans les pays émergents. Mais les comptes sur lesquels les utilisateurs déposent de l'argent n'étaient jusque là pas actifs et fonctionnaient plus comme une solution alternative que comme un compte bancaire. Soit comme un moyen d'échange et non d'épargne. Voilà qui devrait changer avec le lancement cette semaine de M-Kesho par Safaricom et Equity Bank. Le système permettra aux utilisateurs de M-Pesa de déposer ou de retirer de l'argent sur un compte qui sera rémunéré. "Le taux d'intérêt variera de 0,5 % par an pour un compte contenant jusqu'à 2000 KSH jusqu'à 3 % si plus de 10 000 KSH y ont été déposés", explique à L'Atelier Pauline Vaughan, responsable de M-Pesa.

Compte rémunéré et micro-crédit

Les utilisateurs pourront aussi profiter directement de micro-prêts et de produits de micro-assurance. Pour cela, il leur faudra envoyer une requête par SMS à la banque. "Celle-ci accèdera aux transactions effectuées dans les six derniers mois par la personne sur son compte M-Pesa pour calculer le taux du prêt", poursuit la responsable. Et d'ajouter : "Equity Bank pourra aussi accéder aux opérations effectuées sur les autres potentiels comptes du demandeur". L'argent sera ensuite transféré directement sur le compte. "Le micro-crédit sur mobile existe déjà depuis plusieurs années en Afrique, au moins depuis 2008 pour Zap", nuance Philippe Torrès, directeur du conseil à L'Atelier. "Mais ce qui est important avec le rapprochement de Safaricom et d'Equity Bank, c'est leur réseau et le côté 'officiel', prometteurs d'un développement massif". Constat confirmé par Erik Hersman, fondateur d'Ushahidi et du centre d'innovation iHub.

Un marché qui reste fermé

"Une telle initiative est intéressante car elle ouvre l'accès à un compte bancaire à la majorité de la population", a-t-il approuvé lors d'un entretien avec L'Atelier. "Mais", alerte-t-il, "j'aurais aimé que Safaricom noue ce partenariat avec plus d'une banque. Les systèmes de m-paiement qui ne sont pas ouverts posent problème". Et d'ajouter : "Ce dont nous avons besoin, c'est d'un opérateur et d'une banque qui le soient". C'est-à-dire qu'un utilisateur qui utilise Zain et qui a un compte chez Barclay's doit pouvoir envoyer de l'argent à quelqu'un qui utilise M-Pesa, avec Equity Bank. "Ici, il s'agit d'un objectif de croissance à court terme. Le long terme ne leur est pas encore accessible parce qu'ils sont trop centrés sur leur base de consommateurs", poursuit l'entrepreneur. Le montant minimum de dépôt requis pour en ouvrir un est de 100 shillings (KSH). Soit un peu plus d'1 euro. Les cinq dernières transactions seront aussi consultables sur son téléphone.

Source: L'Atelier

Quand l'avatar évalue la pénibilité du travail des ouvriers spécialisés

Afin d'améliorer la sécurité et de réduire la pénibilité du travail sur les lignes d'assemblage, Ford a recours à Santos. Cet ouvrier virtuel permet d'évaluer l'impact à long terme des processus mis en place.

Avant d'entreprendre la construction d'usines et de nouvelles lignes d'assemblages, Ford fait évaluer celle-ci par un avatar baptisé Santos. Ce, afin d'assurer le confort des ouvriers et d'éviter les mouvements pouvant avoir un impact à long terme sur leur santé. L'ouvrier virtuel est équipé d'un système musculaire biomécanique permettant de simuler et de fournir des retours aux chercheurs sur la fatigue, la vitesse, la force et les mouvements de torsion induits par une journée de travail sur une ligne de fabrication. Cela permet également aux chercheurs d'apprécier sa qualité en terme d'ergonomie et de sécurité. "Santos répond à toutes les lois de la physique, il ne se contente pas de simuler un mouvement" indique Tim Marler, un des chercheurs ayant contribué à élaborer l'avatar.

Repérer les mouvements douloureux

"Il enregistre l'effort physique à fournir pour atteindre et soulever un objet". Et d'ajouter "En plus d'effectuer des taches de manière autonome - celui-ci peut parler et répondre à des questions". Sur une tache donnée, il peut par exemple indiquer si l'ouvrier éprouve un mal de dos et sur quelle période ces derniers persisteront, même à une échelle de plusieurs mois ou de plusieurs années. "Notre logiciel utilise une plateforme physique où nous pouvons changer des actions et voir leurs effets", explique un autre chercheur. Ces "dynamiques prédictives" comme il les nomme, s'appuient sur les règles de mouvements du corps humain combiné à des modèles mathématiques complexe.

Trouver la manière optimale d'accomplir une tâche

Et c'est leur combinaison qui permet à l'avatar de fournir au chercheur divers renseignements sur le ressenti des ouvriers, même en changeant les paramètres de l'environnement virtuel. En adaptant ces derniers, il est possible de trouver la manière optimale d'accomplir une tâche. Créé par l'université de l'Iowa, cet avatar fut employé à l'origine par le département américain de la Défense pour trouver des solutions à la tension physique des soldats.Pour Ford, Santos répond à des besoins identiques que ceux du domaine militaire "En analysant les limites humaines dans l'accomplissement de certains mouvements, l'avatar contribue à améliorer l'efficacité des processus aussi bien que la sécurité et la qualité", conclut un responsable de Ford.

Source: L'Atelier

mercredi 19 mai 2010

Les réseaux sociaux seront bénéfiques à la télévision

Pour augmenter leurs revenus publicitaires et attirer les internautes vers leurs programmes, les éditeurs doivent diffuser leurs programmes depuis ces plates-formes.

Les éditeurs de chaînes de télévision doivent intégrer les réseaux sociaux à leur programmation, explique l'Idate dans un rapport*. Cela afin de permettre de regarder un contenu tout en restant connecté à ses amis, et donc en le commentant. Mais aussi d'affiner les systèmes de recommandation de programmes en fonction des choix de ses contacts. Selon le cabinet, une telle initiative est nécessaire pour permettre aux éditeurs de capitaliser sur leurs grilles. Ainsi que d'augmenter leurs revenus publicitaires en étant présents sur des plates-formes très populaires. Enfin, explique l'institut, cela leur permettrait de se procurer de nouvelles sources de revenus en étant rémunérés comme fournisseurs de solutions communautaires.

Des chaînes encore frileuses

Seul bémol : les chaînes s'essaient à quelques tentatives comme l'intégration de réseaux sur leur site, via des solutions de portabilité comme Facebook Connect ou Sign In with Twitter. Ou leur utilisation pour de la promotion et de la diffusion virale. Mais elles n'organisent pas encore la diffusion depuis ces mêmes plates-formes. Pourtant, des sites comme Facebook ont un positionnement favorable à l'hébergement de contenus tiers. Autre chose : la grande majorité de leurs programmes en ligne n'intègre pas de publicité. Ce qui suscite un manque à gagner. Idem du côté de la vidéo à la demande payante.

Vers une social TV

Celles-ci n'intègrent pas encore réellement le graphe social, regrette l'étude. Qui note que cette prudence peut s'expliquer par les risques juridiques de l'exploitation d'un tel graphe. L'arrivée des téléviseurs connectés devrait accélérer le processus. Ceux-ci permettant notamment de rendre disponible l'accès aux plates-formes communautaires depuis son poste grâce à un widget. "La Social TV devrait revaloriser l'expérience télévisuelle, notamment aux yeux des jeunes générations, habituées à réaliser plusieurs tâches en même temps", est-il indiqué dans l'étude.

Source: L'Atelier

Aux US, le mobile est couramment utilisé pour comparer les prix

Un tiers des consommateurs se sert de son téléphone portable pour obtenir des informations sur un produit, ou souscrire à des offres promotionnelles.

Les consommateurs américains sont de plus en plus enclins à utiliser leur mobile pour effectuer des économies sur les produits de première nécessité, indique dans une étude le cabinet Deloitte. Un tiers des personnes interrogées affirme ainsi se renseigner auprès des entreprises et grandes surfaces en souscrivant à des courriers électroniques, ou des coupons via leur mobile. Une augmentation de près de 8 point par rapport à 2008. "Aujourd'hui, les clients n'utilisent pas seulement Internet pour obtenir des informations nutritionnelles ou de santé à propos de la nourriture qu'ils consomment", constate Pat Conroy, responsable de l'étude. "Ils se servent de leur mobile pour comparer les prix et faire leur choix", poursuit-il.

Un rôle clé dans la prise de décision des clients

Pour Deloitte, les smartphones jouent désormais un rôle clé dans la prise de décision des clients, en particulier lorsqu'ils se posent la question du coût des produits. En soulignant l'influence de la conjoncture économique actuelle dans cette évolution. Selon l'étude, près d'un quart des consommateurs reconnaît s'être rendu sur le site d'une grande surface pour obtenir de l'information sur un bien. La même proportion affirme avoir déjà effectué un achat suite à son passage sur l'un de ces sites.

Le portable utilisé en magasin

Un peu moins d'une personne interrogée sur dix au cours de l'étude a affirmé avoir déjà utilisé son portable à l'intérieur même du magasin, pendant ses courses. Pour plus de la moitié d'entre eux, il s'agissait de comparer les prix, ou de recevoir des promotions via des coupons mobiles. Contre moins d'un tiers qui recherchait des informations nutritionnelles. Autre chose : les consommateurs masculins sont plus à même de se servir de leur téléphone pour comparer les prix (près de 60 % des hommes le font, contre moins de 50 % pour les consommatrices).

Source: L'Atelier

L'assistance aux personnes fera le succès de la robotique

Le vieillissement de la population favorisera l'émergence de robots compagnons et capables d'aider les individus au quotidien. Cela principalement en Asie.

Le marché mondial de la robotique atteindra les 21 milliards de dollars d'ici à 2014, contre 10 milliards en 2009, estime un rapport de Markets and Markets*. Principal acteur du secteur : l'Asie, qui génèrera à elle seule plus du tiers des revenus. Selon le cabinet, cet engouement pour la robotique s'explique en grande partie par le fait que le secteur est passé du développement de robots industriels à des robots de service. Ces derniers commençant à être adoptés pour accomplir des tâches considérées comme pesantes, sales, difficiles ou dangereuses par les individus. Mais ce n'est pas tout. Toujours dans cette optique de service, les systèmes robotisés sont aussi perçus comme un moyen d'assistance.

Des robots compagnons

Ainsi, explique Markets and Markets, l'un des moteurs de cette croissance s'explique par un vieillissement de la population : celui-ci crée un besoin pour des systèmes robotisés dédiés à assister les personnes : systèmes d'aide à la réalisation de tâches, robots compagnons…. Le marché des machines domestiques devrait ainsi quasi représenter 70 % de la demande globale dans quatre ans, particulièrement en Asie. L'Europe, puis l'Amérique du Nord, seront aussi demandeurs. Mais cette dernière devrait principalement investir dans des solutions médicales et liées à la défense du territoire.

Des efforts au niveau de la mise en réseau

Deux autres secteurs qui, avec celui du divertissement, profiteront aussi des avancées technologiques en robotique. Le cabinet cite ainsi la généralisation de machines dédiées à la construction, la surveillance, la maintenance, la réalisation d'opérations chirurgicales… Reste que, rappelle le cabinet, même si les industries optent de plus en plus pour une main-d'œuvre robotisée, certains facteurs posent encore problème comme la capacité limitée des robots à travailler dans un environnement non structuré ou en réseau.

*'Global Service Robotics Market (2009 - 2014)

Source: L'Atelier

mardi 18 mai 2010

"Au Kenya, le climat d'investissement high-tech est positif"

eVA Fund est un fonds néerlandais qui injecte de l'argent dans des start-up Internet ou mobile au Kenya et au Ghana. Le but : créer de la croissance à travers l'investissement.

Entretien avec Vincent Kouwenhoven, fondateur et directeur d'eVA Fund, lancé en janvier de cette année en Afrique.

L'Atelier : Pourquoi lancer maintenant un fond d'investissement dédié aux technologies en Afrique ?

Vincent Kouwenhoven : Le continent est en train de prendre rapidement la voie d'Internet et des applications mobiles, dans les grandes villes comme dans les zones rurales. De plus en plus de start-up sont lancées dans ces domaines. Cependant, l'accès à des fonds reste un important inhibiteur de développement. Voici notre coeur de cible. Le capital risque en Afrique en est encore balbutiant. Les entreprises qui veulent se développer, en général, doivent être soit "politiquement connectées" ou suffisamment solvables pour un prêt bancaire. Avec des taux d'intérêt souvent entre 15 et 30 %, cela n'est pas une option viable pour bon nombre d'entrepreneurs. Voilà pourquoi ils accueillent en général favorablement les sociétés de capital risque, qui leur fournissent des fonds, un suivi actif et un accès à un modèle d'affaires éprouvé en échange de parts dans leur compagnie.

Et pourquoi avoir décidé de cibler le Kenya et le Ghana ?

Ces deux pays ont un taux de croissance économique important et attirent des Africains au niveau d'instruction élevé issus de la diaspora. Ils reviennent dans leur pays natal pour lancer des entreprises. Au Kenya en particulier, il y a un esprit entrepreunarial important, avec des individus ambitieux et très connectés. Par ailleurs, l'avantage d'investir dans le web est que ce dernier apparaît comme relativement indépendant de l'agenda politique, tourné vers des secteurs plus traditionnels.

Le fait de déjà investir en Europe dans le secteur technologique facilite-t-il l'identification des initiatives porteuses ?

Effectivement, nous sommes sur le secteur depuis dix ans (eVentures Europe BV). Même si le marché africain est très différent sur bien des aspects, l'utilisation et le déploiement d'Internet montrent aussi de nombreuses similarités avec les premières heures du web aux US et en Europe. Par exemple, Facebook et Google sont aussi en Afrique parmi les sites les plus visités, avec des applications locales spécifiques qui se développent très rapidement.

Des applications souvent très innovantes et qui permettent de s'affranchir de certaines contraintes liées aux infrastructures ou à la pauvreté...

Tout à fait. Les applications mobiles sont même souvent plus innovantes que celles que l'on voit dans le monde occidental. Les solutions de m-paiement en sont un bon exemple, avec le déploiement de nombreux standards innovants. L'une des entreprises dans lesquelles nous investissons, Pesapal, est d'ailleurs en train de lancer une solution pour payer ses factures d'électricité, des frais scolaires etc. depuis son téléphone.

Pensez-vous exporter certains de ces projets en Europe ?

Nous nous concentrons principalement sur des initiatives dédiées aux marchés locaux, mais rien n'est figé. Nous avons ainsi été approchés par une banque néerlandaise intéressée par les technologies de paiement mobile dans lesquelles nous sommes impliqués en Afrique.

Source: L'Atelier

Electricité : les compteurs intelligents jouent collectif

Pour limiter les pics de consommation d'électricité dus au rechargement des appareils de stockage, l'université de Southampton propose de les équiper d'un système de régulation fonction des prix du marché.

"L'installation d'appareils de stockages de l'électricité dans les foyers est perçu comme un moyen efficace pour économiser de l'énergie et réduire la dépendance des réseaux intelligents aux énergies fossiles", explique une équipe de chercheurs de l'université de Southampton. Ceux-ci proposent un système de gestion de ces appareils individuels dont l'objectif est d'optimiser l'utilisation du réseau pour la collectivité. En effet, si tous les bâtiments équipés rechargent leurs appareils au même moment pour bénéficier des périodes creuses, cela provoque un pic de consommation qui diminue voir annule les bénéfices liés à leur utilisation. Le système proposé par les chercheurs britanniques pallie ce problème en équipant les compteurs électriques d'un logiciel chargé de gérer l'utilisation des appareils de micro-stockage (c'est-à-dire leur chargement et leur déchargement).

Converger vers un équilibre de la consommation

"Le système optimise le cycle de chargement et apprend à adapter celui-ci en fonction des fluctuations de prix résultant de la demande du reste de la population", explique à L'Atelier Sarvapali Ramchurn, un des auteurs du projet. Ainsi si l'agent détecte des périodes de forte consommation, il alimentera le foyer en électricité en puisant dans les réserves de l'appareil de stockage. "Le système s'appuie sur un algorithme d'apprentissage standard et le combine avec les prédictions de consommation de l'appareil, en fonction du profil de chaque foyer", précise le chercheur. L'objectif étant de permettre au réseau national d'électricité de converger vers un équilibre de consommation, et ce tout en favorisant les économies individuelles de ses utilisateurs. Au Royaume-Uni, il serait ainsi possible pour un foyer équipé d'un appareil de stockage de 4 kWh, de réduire sa note d'électricité de 13%.

Réduire la note d'électricité

Les chercheurs soulignent que cette situation d'équilibre peut être obtenue sans pour autant avoir à équiper l'ensemble des foyers d'appareils de stockage de ce type. "Notre étude a prouvé qu'il est possible d'y parvenir en équipant à peine 38 % des maisons britanniques d'appareils de ce type", précise Nick Jennings, un chercheur ayant également contribué au projet. "L'avantage de ce système est que si la plupart des maisons l'utilisent pour réduire les pics de consommations, le coût général de l'électricité consommé sera réduit, tout comme les émissions de carbone", précise-t-il. A noter: ce projet qui a été présenté à l'occasion du AAMAS 2010 à Toronto a remporté le prix de la meilleur étude sur un panel de plus de 600 projets.

Source: L'Atelier

lundi 17 mai 2010

Zynga pourrait lancer sa propre plateforme virtuelle et divorcer de Facebook

En ce moment la tension est très forte entre Zynga (le roi de social games) et Facebook (le roi des plateformes sociales). Les raisons de cette tension sont bien évidement économiques mais pourrait avoir d’énormes répercussions si le conflit s’aggravait : Facebook and Zynga Battle Over Credits, and Bigger Platform Issues.

Zynga, le poids lourd des social games

Pour vous la faire courte, Zynga est l’éditeur de social games ayant le plus de succès (Farmville, Mafia Wars, Café World, Texas HoldEm Poker…). Leur force est d’avoir su acquérir en un temps record une grande maitrise des mécaniques de jeux qu’affectionnent les utilisateurs et leurs dernières créations sont des francs succès (Treasure Isle).

7 jeux de Zynga sont dans le Top10 de Facebook

D’après les dernières estimations, les social games de Zynga réunissent 243 millions d’utilisateurs uniques dont 60 millions d’utilisateurs journaliers. Oui c’est énorme, d’autant plus qu’ils ont également mis en place un modèle économique redoutable qui a été stabilisé depuis la tourmente de l’année dernière (Scamville, ou pourquoi les social games ne sont pas la poule aux oeufs d’or). Les revenus proviennent ainsi majoritairement de la vente d’objets virtuels, directement sur le site ou par le biais de cartes prépayées qui sont vendues en grande distribution (les Zynga Game Cards).

Ils éditent également un mini-univers virtuel (YoVille) proposant une plus grande liberté et des modalités d’interactions plus poussées :

YoVille, l'univers virtuel de Zynga

Facebook serait-il devenu trop gourmand ?

Nous avons donc d’un côté Zynga qui est le leader incontesté de son créneau (avec une croissance et une rentabilité très solide) et de l’autre Facebook qui aimerait bien profiter de ce succès pour engranger encore plus de C.A. (ils ont une grosse dette à rembourser). Les hostilités ont donc commencées l’année dernière quand Zynga a essayé de reprendre la main sur ses joueurs en tentant de récupérer leur adresse email. La réponse de Facebook a été immédiate : Ils ont modifié le fonctionnement de la Facebook Platform pour neutraliser le système de notification (un mécanisme essentiel à la croissance des social games).

Le conflit entre les deux sociétés est maintenant bine plus grave puisqu’il est question du coeur même du modèle de revenu : Facebook essaye d’imposer à Zynga sa monnaie virtuelle (les Facebook Credits) et ses conditions (une commission de 30% sur les revenus). Problème : 30% c’est beaucoup, surtout pour une monnaie virtuelle dont le fonctionnement n’est pas encore stabilisé et dont l’éditeur a pris la très mauvaise habitude de changer les règles du jeu quand ça l’arrange.

Partant du principe que Zynga maîtrise sa propre monnaie virtuelle ainsi que son réseau de distribution (les Game Cards), pourquoi devraient-ils se faire imposer les conditions de Facebook ? Ils ont donc entamé l’année dernière une stratégie de désengagement avec notamment le lancement de FarmVille.com et plus récemment celui de YoVille.com. Le but de cette manoeuvre étant de réduire leur dépendance aux réseaux sociaux (cf. Zynga Shutting Down YoVille On Tagged, Opening YoVille.com).

Le fait d’héberger ses propres jeux est un plus indéniable car cela leur donne toute liberté sur les évolutions technologiques et sur les leviers de monétisation. Un luxe que seul Zynga semble pouvoir se permettre car ils ont dépassé depuis longtemps la masse critique d’utilisateurs nécessaires. Pour les éditeurs de plus petite taille c’est une autre histoire : Ils n’ont d’autres choix que de se faire imposer les conditions de Facebook (cf. Facebook’s Darth Vader Grip On Game Publishers).

Vers une indépendance totale de Zynga ?

Sur sa lancée, Zynga envisage donc de passer à la vitesse supérieure et de lancer son propre portail de casual gaming (Zynga Live) afin de couper totalement les points avec les réseaux sociaux : Zynga plans Zynga Live site to diversify away from Facebook. Certes, la manoeuvre est risquée et Zynga a toutes les chances de voir ses revenus baisser (Zynga’s Profit Machine At Risk) mais j’imagine que l’opportunité de piloter son propre navire est tentante.

Les modèles sud coréens et japonais (Nexon, Ijji, NCSoft, NDoors, gPotato, GamesFirst…) doivent motiver les patrons de Zynga à acheter leur indépendance, car il y aura bien un prix à payer.

Un rapport de force inversé : Rentabilité vs. audience

Dans cette histoire j’ai le sentiment que Zynga est tout de même en rapport de force par rapport à Facebook malgré l’audience colossale de ce dernier. Le problème est que l’audience ne vaut rien si elle n’est pas transformée en bénéfices. Et sur ce point-là Facebook c’est rendu dépendant de Zynga car ils comptent bien sur leur commission de 30% pour remplir leurs caisses. Rappelez-vous que dans l’absolu, Facebook n’est qu’un intermédiaire. Et l’intermédiaire est celui qui est dans la position la plus fragile, même avec 400 millions (ou 1 milliards) d’utilisateurs.

Il y a toutes les chances pour que la séparation ai lieue, mais dans un contexte plus serein : DST, l’investisseur commun des deux sociétés, saura calmer le jeu. Mais il ne calmera certainement pas l’inquiétude des éditeurs de plus petite taille qui seront toujours tributaires du bon vouloir de Facebook et de ses changements réguliers de conditions générales d’utilisation. Donc dans cette histoire, c’est tout l’écosystème de Facebook qui pourrait être déstabilisé.

C’est donc un sacré challenge que Zynga doit relevé, mais pas le dernier car ils devront également mener bataille sur le terrain des mobiles avec un autre acteur de taille (et pas moins féroce) : Apple. Affaire à suivre…

Source: VirtualWorlds, de Fred Cavazza

EVE (Evolutive Virtual Environment): Le futur de la réalité virtuelle et augmentée à Saclay

La plateforme EVE est composée d’une dalle rétro projetée de 13 m2 et de plusieurs écrans de 5 mètres de haut.

La plateforme EVE est composée d’une dalle rétro projetée de 13 m2 et de plusieurs écrans de 5 mètres de haut.Spécialisé dans la recherche sur de nouvelles formes d’interaction homme-machine, le laboratoire LIMSI du CNRS a conçu EVE (Evolutive Virtual Environment), un dispositif immersif et multi-sensorimoteur de réalité virtuelle et augmentée.

Immersion et interaction entre réel et virtuel

Conçu par le laboratoire CNRS d’informatique pour la mécanique et les sciences de l’ingénieur (LIMSI) et cofinancé par le CNRS, le réseau Digiteo et la région Ile-de-France, EVE est le résultat de plusieurs années de recherche sur l’immersion et l’interaction d’humains dans des scènes où se combinent réel et virtuel. « La réalité virtuelle offre des possibilités très nombreuses dans tous les domaines d’activités, mais pour concrétiser des projets de recherche, il était nécessaire de disposer d’une plateforme à la pointe de la technologie comme c’est le cas aujourd’hui avec EVE. Cette réalisation servira notamment à des recherches sur le travail collaboratif, dans le cadre de Digiteo » rapporte Maurice Robin, directeur de Digiteo.

Sensations tactiles et retours d’effort avec des objets virtuels

Installée au sein du LIMSI sur le campus de l’Université Paris-Sud 11 à Orsay, la plateforme EVE est dotée d’une nouvelle génération d’applications 3D (applications immersives multi-utilisateurs, interfaces dotées d’intelligence, rendus audio 3D) et de périphériques haptiques permettant des sensations tactiles et des retours d’effort avec les objets virtuels. Des interactions sont ainsi rendues possible via six canaux : parole, capture de mouvements, analyse de gestes, feedbacks tactilo-kinesthésiques, audio 3D, relief visuel.

Des recherches en cours

Deux projets de recherche s’appuient d’ores et déjà sur le dispositif EVE. Le premier est un démonstrateur utilisant des données de PSA Peugeot Citroën pour travailler sur l’immersion multi-sensorimotrice pour des interactions collaboratives co-localisées. Le second présente un dispositif de télé-présence pour la supervision multi sensorielle de tâches distantes. Pour cette démonstration, un véhicule équipé d’une caméra stéréo et d’un capteur audio 3D « fixés sur une tête motorisée partiellement asservie aux mouvements de l’utilisateur distant » transmettent par Wi-Fi les informations collectées à EVE qui les présentent dans une scène « virtualisant » son environnement statique et « augmentant » la réalité par des informations non prévisibles (la présence de piétons par exemple).

Source: Le Journal de l'Innovation

Google’s Nexus One Store Is Going Out Of Business Read more: http://techcrunch.com/2010/05/14/googles-nexus-one-store/?utm_source=feedburner&utm_medi

When Google launched its Nexus One Android phone, it also launched alongside it an online phone store

When Google launched its Nexus One Android phone, it also launched alongside it an online phone store where the Nexus One and future Android phones would be for sale. It was a slightly disruptive play to de-link the purchase of a phone from an actual carrier. The idea was, you could pick your phone, pick your plan, and mix and match.

where the Nexus One and future Android phones would be for sale. It was a slightly disruptive play to de-link the purchase of a phone from an actual carrier. The idea was, you could pick your phone, pick your plan, and mix and match.

Well, it didn’t turn out that way. Carriers don’t like to give up control. In fact, Verizon decided not to sell the Nexus One at all, and instead opt for its own more Incredible Android phone. The phone store turned out to be a flop, and Google just announced that it will be closing up shop online :

:

While the global adoption of the Android platform has exceeded our expectations, the web store has not. It’s remained a niche channel for early adopters, but it’s clear that many customers like a hands-on experience before buying a phone, and they also want a wide range of service plans to chose from.

The Nexus One phone will still be available through carrier partners. But Google’s online phone store will become an “online store window” showcasing Android phones available globally—directly from the carriers. Google has enough on its hands going up against Apple. It needs the carriers on its side if it wants to win the bigger battle.

mercredi 12 mai 2010

WiGig, futur standard du haut débit sans-fil ?

Pour faciliter la transmission de données sans-fil en haut-débit, la Wi-Fi Alliance et la Wireless Gigabit Alliance (WiGig) annoncent un accord de coopération. Celui-ci repose sur le partage des spécifications technologiques pour le développement du futur programme de certification de la Wi-Fi Alliance acceptant l'échange d'informations sans fil dans la bande de fréquence des 60 GHz. Technologie éponyme sur laquelle la WiGig travaille déjà depuis un an. Le but : favoriser le développement d'appareils tribande capables d'emprunter les bandes 2,4 et 5 GHz, mais aussi 60 GHz.

Transférer des fichiers en haute définition

La dernière technologie devenant compatible et complémentaire de celles préexistantes. Ce qui permettrait de faciliter son adoption par l'industrie. En clair, il sera possible de transférer du contenu très consommateur de bande passante comme des vidéos en haute définition depuis un grand nombre d'appareils Wi-Fi. "Cette connectivité améliorera les capacités des technologies Wi-Fi actuelles", note Edgar Figueroa, responsable de la Wi-Fi Alliance.

Publication des spécifications

Cette annonce est faite au moment où la WiGig Alliance explique avoir finalisé et publié les spécifications de cette technologie. Celle-ci devrait permettre de transférer des données jusqu'à 7 Gb par seconde. L'institution regroupe des acteurs comme Cisco, Nokia, Dell ou Microsoft. Elle a été mise au point pour unifier la prochaine génération de produits sans-fil à haut débit. Et par conséquent pour encourager l'adoption de la bande des 60 GHz.

Source: L'Atelier

mardi 11 mai 2010

Voiture électrique : GE et Nissan associés pour la batterie

Source: Le Journal de l'Innovation

lundi 10 mai 2010

Apple is now Nintendo’s biggest problem

The last time Nintendo took a big hit in profit, it resulted in the development of perhaps the most successful video game console of all time in the Wii. What’s Nintendo’s response going to be this time around? Yes, the big N has seen its profits drop from $3.03 billion to $2.48 billion—still a fair a bit of money perhaps to you and me, but cause for panic in the house that Mario built. While a traditional rival, Sony (with the PlayStation), was responsible for the previous rough patch, this time it’s Apple. Will Nintendo allow the iPhone to push it around?

The last time Nintendo took a big hit in profit, it resulted in the development of perhaps the most successful video game console of all time in the Wii. What’s Nintendo’s response going to be this time around? Yes, the big N has seen its profits drop from $3.03 billion to $2.48 billion—still a fair a bit of money perhaps to you and me, but cause for panic in the house that Mario built. While a traditional rival, Sony (with the PlayStation), was responsible for the previous rough patch, this time it’s Apple. Will Nintendo allow the iPhone to push it around?

Not likely. Nintendo’s president, Satoru Iwata, the man who essentially willed the company to success in the past several years—he was more or less responsible for the Wii—has told his sergeants to treat Apple as the company’s most significant threat from here on out. That honor used to belong to Sony, but Sony is so last generation, especially when focusing on mobile gaming. If Nintendo’s future mobile platforms are to be any kind of success, the company will have to figure out how to take on the ease of use afforded by the App Store.

You’re sitting on a park bench, whip out your iPhone, launch the App Store, and buy Angry Birds for 99 cents. Zero to gaming in no time at all. How’s Nintendo going to compete with that? (The DSi Shop requires Wi-Fi, whereas the App Store will load anywhere you have a cellphone signal.)

There’s a lot going on here. Nintendo insiders may be worried about the iPhone-App Store nexus, but surely they realize that there’s a world of difference between playing a long role-playing game like Chrono Trigger on the DS and playing, I don’t know, Bejeweled 2 while waiting for the subway to arrive. Just as the Wii “changed gaming” by expanding its audience, so, too, has the iPhone.

Part of the problem is that the word “gaming” is entirely too vague to accurately describe both playing Chrono Trigger for 40 hours and Bejeweled 2 for two minutes at a clip. Do those two activities belong in the same genre, “gaming”? To me, they’re two different things.

The Wii was released in late 2006, and only now are Microsoft and Sony incorporating the concepts introduced by it, namely motion controllers and simpler games.

Maybe Nintendo should just release a phone?

Source: Techcrunch

Chine : Nokia cible les consommateurs ruraux

Le constructeur propose sa suite d'outils Life Tools aux internautes chinois vivant dans des zones isolées. Ils bénéficieront d'informations liées à la santé, l'agriculture et de modules d'apprentissage de l'anglais.

Pour intensifier sa présence en Chine, il faut cibler les populations rurales, juge Nokia. Qui annonce lancer la suite de services Life Tools sur le territoire. Ces outils, disponibles depuis la plate-forme Ovi du fabricant, proposent des informations régulièrement actualisées dans les domaines de la santé, de l'agriculture ou encore de l'éducation. Les données sont envoyées par SMS, en chinois simplifié. "Nous considérons qu'il y a une vraie attente pour des solutions mobiles dans les marchés émergents, avec des informations de qualité, à un prix abordable, et localisées", note Chris Leong, vice président du marketing chez Nokia Asie.

Cibler la population rurale chinoise

Dans le détail, les services proposent des informations basiques concernant les données météorologiques, les prix du marché pour les agriculteurs, ou encore les soins médicaux (hépatite B, asthme, mais aussi suivi de grossesse). Les utilisateurs pourront aussi souscrire à un programme d'e-learning, offrant principalement des cours en anglais, et des conseils de langue. "Les téléphones mobiles sont largement utilisés dans les zones rurales. Pour beaucoup, c'est même leur première source d'information", précise Sun Xiaoming, du ministère chinois des Sciences et des Technologies.

Des informations basiques

Celui-ci ajoute que la population totale des Chinois résidant en zone rurale avoisine les 730 millions de personnes. Soit plus de 50 % de la population de l'ensemble du pays. Un marché important. A noter : pour l'instant, les outils sont mis à disposition exclusive des utilisateurs de Nokia 1616 et Nokia 1800. A terme, ils pourront être intégrés à d'autres portables. Pour bénéficier de chacun de ces services, il faut de fait payer un forfait mensuel, à hauteur de 8 yuans pour l'outil à destination des agriculteurs, par exemple.

Source: L'Atelier

mercredi 5 mai 2010

Numericable met le cap sur la 3D et les paris en ligne

Numericable s'est ainsi associé à Panasonic, Cisco, Nagravision et Sagemcom pour fonder la 3D-HD Alliance, dont le rôle sera de promouvoir « la 3D en qualité haute définition et d'accélérer son adoption par le grand public ».

Dans ce cadre, le câblo-opérateur indique qu'il va rendre, en coopération avec Sagemcom, l'ensemble de ses décodeurs HD compatibles avec la 3D « grâce à une simple mise à jour logicielle ». Aucune date n'est précisée. Les abonnés qui possèdent un téléviseur 3D pourront accéder à un portail de vidéo à la demande cet automne, conçu en partenariat avec Nagravision (contenu et interfaces) et Cisco (infrastructure de distribution). Le FAI n'en dit guère plus pour l'instant, en matière de contenus comme de prix. Affaire à suivre, donc.

Parier avec sa télécommande

Autre nouvel axe de développement pour Numericable : les paris sportifs en ligne. L'entreprise a conclu un partenariat avec BetClic pour permettre à ses abonnés de parier directement avec leur télécommande pendant la retransmission d'un événement sportif. Pour ce faire, il faudra avoir auparavant créé un compte BetClic. Il suffira ensuite d'appuyer sur la touche rouge de la télécommande pour parier grâce à la barre de navigation.

Les deux groupes se lanceraient avant Noël, ce qui permettra d'avoir d'ici là un cadre réglementaire enfin clarifié : la loi a été adoptée le 31 mars, mais fait l'objet d'un recours devant le Conseil constitutionnel.

A l'occasion de cette conférence de presse, Numericable a par ailleurs indiqué que les chaînes de télévision feraient l'objet d'une nouvelle numérotation à compter de ce mois. Il a aussi mentionné que son offre I-TNT à 19,90 euros par mois (accès Internet, téléphonie et TNT gratuite) était désormais accessible à 5 millions de foyers, avec l'objectif de 8 millions d'ici à la fin de l'année.

SOURCE : 01NET